客户端的计算机一般都话在家庭、公司网络上,但服务器的部署不仅限于家庭和公司中。

网络包通过最近的POP中的路由器、接入网以及服务器端路由器之后,就直接到达了服务器。其中路由器的包转发操作,以及接入网和局域网中包的传输过程和之前的没有什么区别。

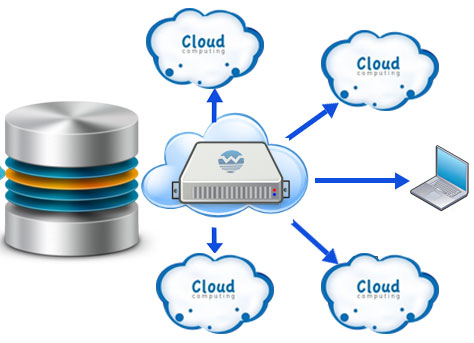

现在大部分是将Web服务器部署在数据中心。数据中心是与运营商核心部分的NOC直接连接的,或者是与运营商之音质枢纽IX直接连接的。

也就是说数据中心通过高速线路直接连接到互联网的核心部分,因此将服务器部署在这里可以获得很高的访问速度,当服务器访问量很大时这是很有优势的。

防火墙的结构和原理无论服务器部署在哪里,现在一般会在前面部署一个防火墙,如果包无法通过防火墙,就无法到达服务器。通常是通过包过滤的方式来实现。

包过滤方式的防火墙可根据接收方IP地址、发送方IP地址、接收方端口号、发送方端口号、控制位等信息来判断是否允许某个包通过。防火墙不会检查通信数据的具体内容,因此无法抵御隐藏在通信数据内容中的攻击。

通过将请求平均分配给多个服务器来平衡负载随着访问量的增加,Web服务器的处理能力会不够用,对于访问量很大的大型网站来说,必须考虑到这一点。

当很用户同时访问时,无认服务器的性能再好,仅靠一台服务器还是难以胜任的。在这种情况下,使用多台服务器来分担负载的方法更有效。这种架构统称为分布式架构。

要采用这种方法,必须有一个机制将客户端发送的请求分配到每台服务器上。可通过使用负载均衡器。

首先要用负载均衡器的IP地址代替Web服务器的实际地址注册到DNS服务器上。判断条件很多种,如果操作没有跨多个页面,则可以根据Web服务器的负载状况来进行判断。

另一种减轻Web服务器负担的方法是将访问过的数据保存在缓存服务器中,当再次访问时直接使用缓存的数据。除了在服务器端部署缓存服务器外,在客户端也可以部署缓存服务器。

缓存服务器是一台通过代理机制对数据进行缓存的服务器。缓存服务器通过更新时间管理内容。

缓存服务器和负载均衡器一样,需要代替Web服务器被注册到DNS服务器中。然后客户端会向缓存服务器发送HTTP请求消息。之后,我们需要判断应该将请求消息转发给哪个Web服务器。

上面说的是在Web服务器一端部署一个代理,然后利用其缓存功能来改善服务器的性能,还有一种方法是在客户端一侧部署缓存服务器。缓存服务器使用的代理机制最早就是话在客户端一侧的,这才是代理的原型,称为正向代理。当时的正向代理还有实现防火墙的功能。

我们可以通过请求消息中的URI中的目录名与Web服务器进行关联,使得代理能够转发一般的不包含完整网址的请求消息,服务器端的缓存服务器正是使用了这种方式, 称为反向代理。

缓存服务器判断转发目标的方法还有一种,那就是查看请求消息的包头部。因为包的IP头部中包含接收方的IP地址,只要知道了这个地址,就知道用户要访问哪台服务器了。这种方法称为透明代理。

内容分发服务是从缓存服务器发展而来的,它在互联网中部署很多缓存服务器,并将用户的访问引导到最近的缓存服务器上。

当缓存服务器放在服务端时,可以减轻web服务器的负载,但无法减少互联网中的流量。如果在客户端部署缓存服务器,就可以不受或者少受这些拥塞点的影响,但是客户端的缓存服务器是归客户端运营管理者所有。

不过Web服务器运营者可以通过和网络运营商签约,将可以自己控制的缓存服务器放在客户端的运营商处。有专门从事部署这个的厂商,称为CDSP。他们来部署缓存服务器,并租借给Web服务器运营者。 这种服务称为内容分发服务。

版权申明:本站文章均来自网络,如有侵权,请联系01056159998 邮箱:itboby@foxmail.com

特别注意:本站所有转载文章言论不代表本站观点,本站所提供的摄影照片,插画,设计作品,如需使用,请与原作者联系,版权归原作者所有